人工智能有偏见和歧视吗?该算法是否使用户喜欢同样的方式?

正如你可能已经注意到的,当你在电影评级网站上给你刚看过的电影打分时,该网站推荐给你的电影风格将与你看过的电影相似。举个更常见的例子,当你在购物网站上搜索某一商品时,第二天推荐页面会显示类似的模型。

人工智能可以帮助企业获取客户偏好,但同时也逐渐根据用户的反馈,形成偏好偏差,使用户需要同化。不仅如此,在人脸识别领域,算法的歧视和偏见所引起的问题引起了很多争议。

最近,一些大学学者的研究结果提供了上述偏见和歧视的证据。他们的研究论文现在可在预印本网站 arXiv 上查阅。

算法推荐系统放大了偏见,使用户喜欢它。

推荐系统的本质是一种基于产品内容或用户行为的信息过滤。今天,我们使用的许多应用程序和网站都嵌入了算法推荐系统。如果在视频站点上给电影高分,系统会向您推荐更多的同类电影。如果您将推荐给系统的电影打分,系统会将您的反馈行为添加到系统中,这是一个反馈循环。

然而,推荐算法会受到流行偏见(流行偏见)的影响。流行偏见意味着一些热门项目经常被推荐,而另一些则被忽略。在上面的例子中,一些电影被更多的人喜爱,得到更高的分数,属于流行项目,或者被称为热门项目,这些项目将更多地被推荐给用户,这就是流行病偏见。

流行偏见的出现在一定程度上是由于培训数据本身的不同受欢迎程度不同,另一部分原因来自推荐算法。随着时间的推移,这种流行病偏见将得到加强。因为如果用户在反馈周期中继续为流行电影获得高分,这些影片就会变得更受欢迎,更有可能被推荐。

为了研究反馈周期对推荐系统放大偏差等方面的影响,Eindhoven 科技大学、德保罗大学和科罗拉多博尔德大学的研究人员使用了三种推荐算法来模拟推荐系统在电影数据集上的交互作用。

作为这项研究的数据,MovieLens1M 数据集包含了 6040 个用户对 3706 部电影的 1000209 个评分,分数从 1 到 5 分不等。研究人员使用的三种推荐算法是基于用户的协作过滤(UserKNN)、贝叶斯个性化排序(Bpr) 和向所有人推荐最受欢迎产品的 mostPopular 算法。

通过使用这些数据和算法来迭代 -- 系统继续为用户生成推荐列表,用户继续对推荐列表中的项目进行评分,研究人员发现,随着时间的推移,这三种算法下的数据的平均受欢迎度有所增加,但总体多样性却有所下降,这证明了反馈周期后推荐系统的偏差被放大了。

流行病偏见的扩大也改变了系统对用户兴趣的判断。在所有推荐算法中,用户偏好与初始偏好之间的偏差随着时间的推移而增大。换句话说,这将导致推荐系统越来越偏离用户的真实偏好,推荐给您的电影系统将不再符合您的喜好。

此外,由于推荐系统的偏见被放大,用户只能访问流行项目,只能看到更多人获得高分的流行电影。因此,在推荐系统中,他们的偏好将集中在一个共同的范围内,体现在用户偏好的同质化上。反馈周期造成的偏见对少数用户的影响更大。

算法偏差的解决方案已经变得至关重要。因为如果处理不当,推荐系统中的一个小偏差也会随着时间的推移被放大。研究人员在论文末尾写道。

用于训练的人脸识别数据有很大的偏差。

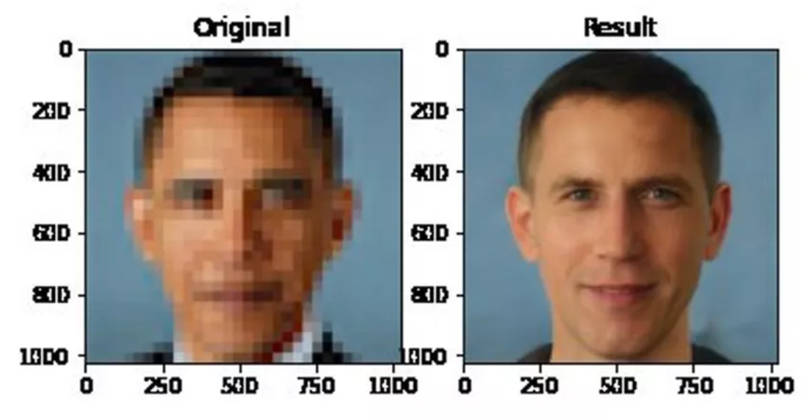

越来越多的人关注人脸识别算法带来的偏见。例如,澄清模糊照片的脉冲算法使美国前总统巴拉克·奥巴马(Barack Obama) 模糊的照片 "恢复了一张白色的脸",在美国的 BLM 运动背景下引发了很多争议,在美国,黑人布莱克·利夫斯·马特(BlackLivesMatter) 的生活正如火如荼地展开。

在人脸识别领域,算法出现偏差和区别的一个重要原因是用于训练的数据集存在很大的偏差。剑桥大学和中东科技大学的研究人员从两组用于识别人脸和表情的数据中发现了证据。

这两个数据集分别是 RAF-DB 和 CelebA。其中,RAF-DB 包含成千上万张来自互联网的图片,包括面部表情和属性评论,而 CelebA 有 202599 张图像,其中包含了 10177 人的 40 条属性注释。

为了确定这两个数据集偏离的程度,研究人员对随机子集进行采样,并对图像进行剪裁,以使人脸保持方向一致。然后,他们使用分类器来衡量准确性和公平性。

从理论上讲,为了保持算法的准确性和公平性,这种分类器应该在整个过程中为不同的群体提供相似的结果。但事实并非如此。

在 RAF-DB 数据库中,绝大多数图片来自 20 至 39 岁的白人。根据具体数据,77.4% 的照片来自白人,15.5% 来自亚裔,7.1% 来自非裔美国人;就性别而言,56.3% 的女性和 43.7% 的男性;超过一半的照片来自 20 至 39 岁的年轻人,甚至不到 10% 的三岁及以上的人。

为了进一步研究数据库中的偏见程度,研究人员使用三种算法对数据库的准确性和公平性进行了评价。结果表明,RAF-DB 数据库识别少数民族的准确率低于白人;在公平方面,性别属性相对公平(97.3%),种族和年龄的公平性相对较低(88.1% 和 77.7%)。

在 CelebA 数据库中,妇女的比例为 61.4%,而男子为 38.6%。就年龄而言,年轻人占 75.7%,大大超过老年人的 24.3%。

在准确性方面,CelebA 数据库对年轻女性的准确率为 93.7%,而对老年男性的准确率为 90.7%,数据库在性别和年龄方面的公平性分别为 98.2% 和 98.1%。

许多公司使用人脸识别软件对受访者的情绪进行评级,如果整个系统存在偏见,对受访者意味着不公平。面部表情数据中存在偏见,这也凸显了监管的必要性。如何利用法律来防止技术滥用,已成为未来这一领域值得思考的问题之一。